Par Ionos

De nos jours, le Big data et le cloud computing sont sur toutes les lèvres et s’accompagnent de mots tendance comme industrie 4.0, Internet des objets ou conduite autonome. Ces technologies requièrent la mise en réseau d’un très grand nombre de capteurs, d’appareils et de machines. Cela génère une quantité de données phénoménale qui devra être traitée en temps réel et se traduire par des actions immédiates sur le terrain. Que ce soit dans un cadre industriel ou privé, dans le domaine scientifique ou dans la recherche, cette quantité de données croît de façon exponentielle. À l’heure actuelle, chaque minute voit la création d’env. 220 000 posts Instagram, 280 000 tweets et 205 millions d’Emails.

Avec de tels chiffres, il n’est pas toujours aisé de prévoir quelles capacités seront nécessaires à tel ou tel moment. Afin de pouvoir réagir à des exigences évoluant aussi rapidement, les capacités sur les serveurs doivent être évolutives. Dans notre guide sur l’hyperscale computing, vous découvrirez quelles structures physiques sont nécessaires pour y parvenir et comment faire pour qu’elles s’articulent de la meilleure façon possible. Avec ces connaissances, vous pourrez opter pour les solutions de serveur répondant le mieux à vos exigences.

Qu’est-ce que l’hyperscale ?

Le terme « hyperscale » peut se traduire en français par « hyperconvergence ». En informatique, cette notion est utilisée pour désigner une certaine forme d’organisation de serveurs.

Le terme « hyperscale » décrit des systèmes de cloud computing évolutifs dans lesquels un très grand nombre de serveurs sont reliés ensemble au sein d’un réseau. Le nombre de serveurs utilisés peut être revu à la hausse ou à la baisse en fonction des besoins. Un réseau de ce type peut traiter un nombre incroyable d’accès, mais aussi mettre à disposition des capacités plus restreintes en cas d’utilisation plus faible.

L’évolutivité est l’expression qui traduit la capacité d’un réseau à s’adapter à des exigences de performance changeantes. Les serveurs hyperscale sont des systèmes petits et simples conçus précisément pour atteindre un but défini. Pour parvenir à cette évolutivité, les serveurs sont mis en réseau de façon horizontale. Le terme « horizontal » décrit ici le fait que d’autres capacités de serveur peuvent être ajoutées afin d’augmenter la performance d’un système informatique. Dans la littérature internationale, on utilise également le terme anglais « scale-out » pour traduire ce même phénomène.

L’approche inverse dite d’évolutivité verticale (scale-up) décrit l’expansion d’un système local existant. Dans ce cadre, un système informatique existant est équipé avec un matériel supérieur, c’est-à-dire une plus grande mémoire principale, un processeur ou une carte graphique plus rapides ou des disques durs plus performants. Dans la pratique, avant de procéder à une évolutivité horizontale, la technologie est souvent mise à niveau sur site jusqu’aux limites de ce qui est techniquement possible ou acceptable en termes de rapport coûts/matériel. Une fois ce stade atteint, le passage à l’hyperscale est généralement inévitable.

Comment fonctionne l’hyperscale ?

L’hyperscale computing consiste à mettre en réseau des serveurs simples de façon horizontale. Dans ce contexte, le mot « simple » ne signifie pas « primitif », mais « facilement combinable » avec d’autres matériels. Il existe donc peu de conventions de base, comme des protocoles réseau ce qui permet une communication facile à gérer entre les serveurs.

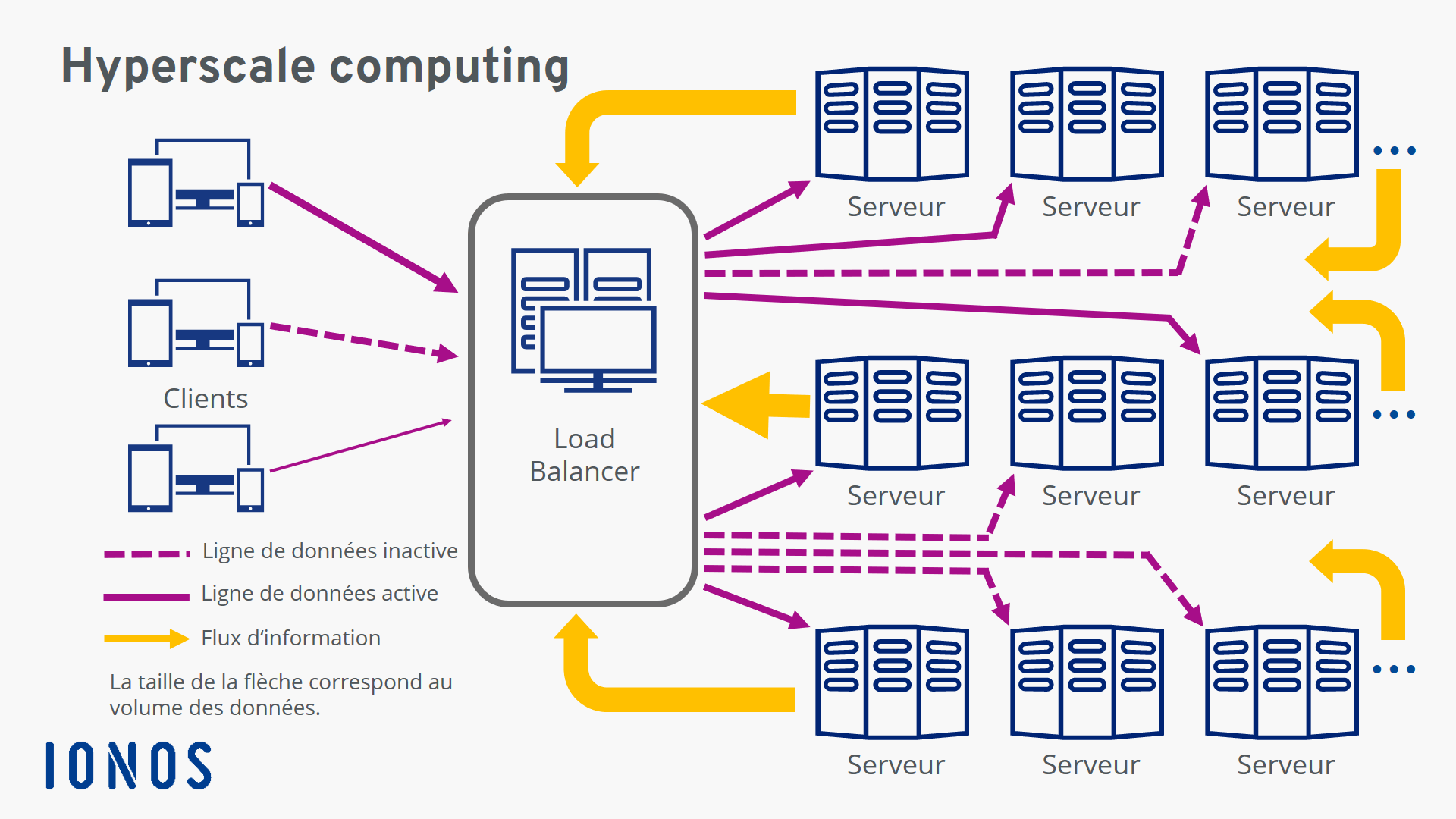

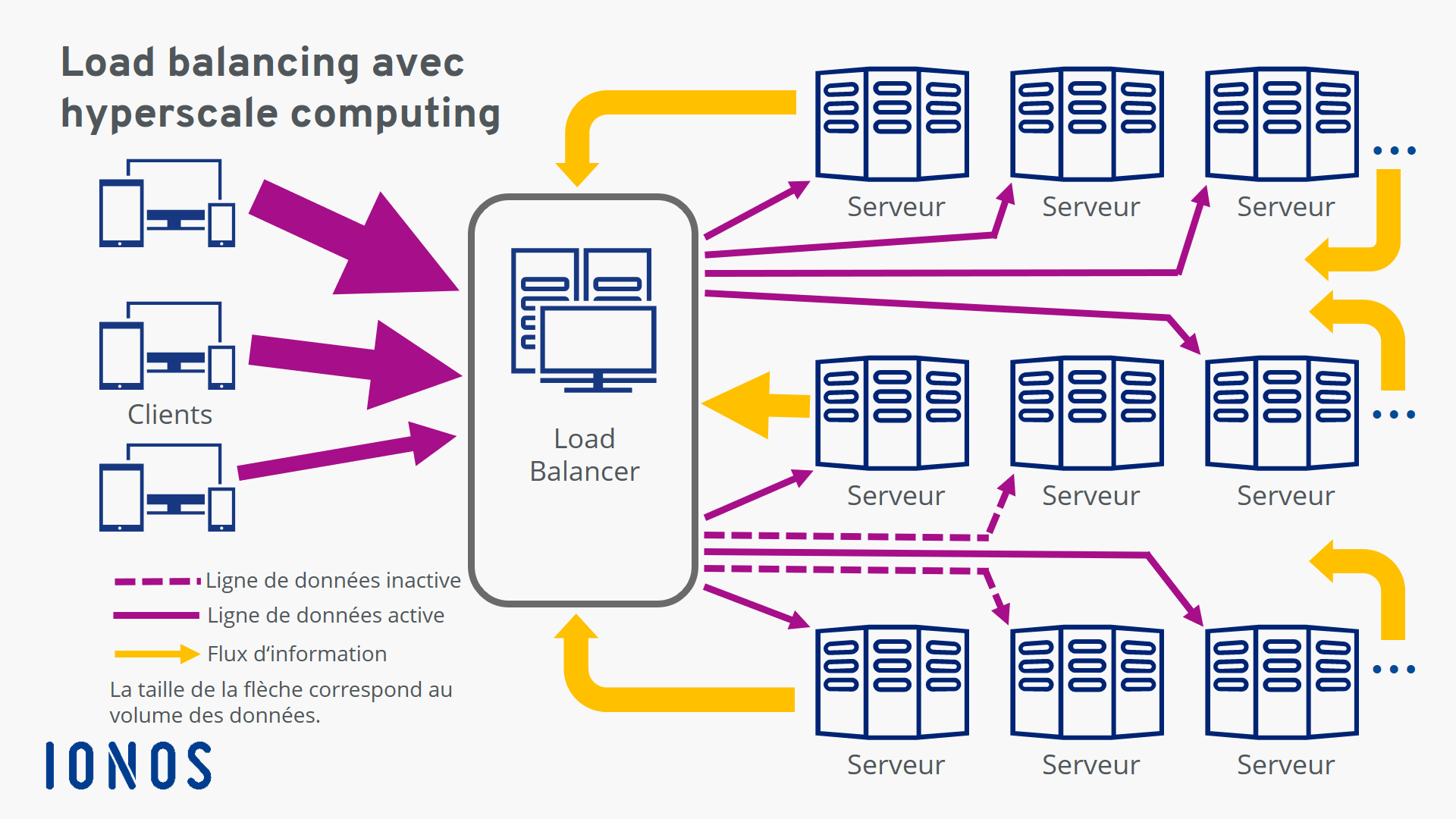

L’« adressage » des serveurs nécessaires à un moment donné s’effectue avec un ordinateur, appelé load balancer, qui gère les requêtes entrantes et les répartit entre les capacités disponibles. Dans ce cadre, la charge des serveurs résultant des volumes de données à traiter est contrôlée en permanence et d’autres serveurs sont activés en cas de besoin ou désactivés si le nombre de requêtes baisse.

Différentes analyses ont montré que seuls 25 à 30 % des données présentes dans les entreprises étaient activementutilisées. Parmi les données non utilisées, on trouve notamment les copies de sécurité, les données clients et les données de restauration. En l’absence de système d’organisation rigoureux, ces données sont difficiles à localiser lorsqu’elles sont nécessaires. Dans le cas de sauvegardes, cette recherche peut parfois demander des jours. L’hyperscale computing simplifie tout cela. Avec cette approche, il n’existe qu’un seul point de contact entre l’intégralité du matériel pour le computing, la mémoire et les réseaux d’une part et les sauvegardes de données, les systèmes d’exploitation, et les autres logiciels nécessaires d’autre part. Associer le matériel à des dispositifs de soutien permet d’étendre l’environnement de computing actuellement nécessaire à plusieurs milliers de serveurs.

Cette méthode permet de limiter les copies de données excessives et de simplifier l’application des directives et des contrôles de sécurité dans les entreprises ce qui, à terme, baisse également les coûts de personnel et de gestion.

Avantages et inconvénients de l’hyperscale computing

La possibilité d’étendre ou de réduire en toute simplicité les capacités de serveurs présente à la fois des avantages et des inconvénients.

Les avantages

- Cette évolutivité ne connaît aucune limite et permet aux entreprises de rester flexibles face à de futurs volumes de données. Permet une adaptation au marché rapide et économique.

- Les entreprises doivent disposer de stratégies à long terme pour le développement de leur propre infrastructure informatique.

- Les fournisseurs d’hyperscale computing garantissent une sécurité élevée contre les pannes grâce à des solutions redondantes.

- Évite les dépendances grâce à l’utilisation de plusieurs fournisseurs en parallèle.

- Des coûts clairement calculables et une rentabilité élevée favorisent la réalisation des objectifs de l’entreprise de façon optimale.

Les inconvénients

- Les données arrivent de manière incontrôlée.

- Les capacités de mémoire/serveur nouvellement ajoutées peuvent également être source d’erreur.

- Les exigences en matière de gestion interne et de responsabilité des employés sont plus importantes – sur le long terme, c’est toutefois un avantage.

- Les utilisateurs deviennent dépendants du modèle de prix du fournisseur d’hyperscale.

- Chaque fournisseur a sa propre interface d’utilisation.

Afin de pouvoir mieux peserle pour et le contre, les entreprises peuvent emprunter une voieintermédiaire et stocker les sauvegardes importantes ou les données rarement utilisées sur un Cloud. De cette façon, ces données n’occuperont pas les capacités de serveur d’un centre de calcul interne. On peut citer comme exemple les données personnelles des utilisateurs d’une boutique en ligne devant être restituées ou supprimées à la demande de l’utilisateur ou les données d’entreprise concernées par une obligation de conservation.

Qu’est-ce qu’un « hyperscaler » ?

On entend par « hyperscaler » l’exploitant d’un centre de calcul proposant des services de Cloud computing évolutifs. Amazon est la première entreprise à avoir occupé ce marché en 2006 avec les Amazon Web Services (AWS). Il s’agit d’une filiale de la multinationale permettant à Amazon de mieux répartir la charge de données entre les différents centres de calcul de l’entreprise. AWS propose aujourd’hui de très nombreux services spécifiques. Sa part de marché est d’environ 40 pour cent. Les deux autres grands acteurs de ce marché sont Microsoft avec le service Azure (2010) et la Google Cloud Platform (2010). L’entreprise IBM est elle aussi un grand fournisseur d’hyperscale computing. Ces possibilités techniques sont également proposées en France à travers les centres de calcul de partenaires autorisés. Depuis l’entrée en vigueur du nouveau règlement général sur la protection des données personnelles, il s’agit d’une considération importante pour de nombreuses entreprises.